このサイトはアフィリエイト広告を利用しております

- RTX 6000 Ada・H100・RTX 5090とどれを選ぶべきか?|Blackwell世代AIワークステーションGPU導入判断ガイド

- 第1章|Blackwell世代アーキテクチャ技術解説

- 第2章|VRAM96GBの実運用メリット

- 第3章|マルチGPU拡張検証

- 第4章|ローカルLLM運用性能

- 第5章|生成AIワークフロー構築

- 第6章|AI動画生成性能

- 第7章|Linux最適化運用|Ubuntuワークステーションチューニング

- 第8章|CUDA・cuDNN設定|AI基盤構築手順

- 第9章|Linuxカーネルチューニング|HPC性能最大化

- 第10章|HPC科学技術計算性能

- 第11章|Docker・コンテナAI運用性能

- 第12章|仮想化・ハイパーバイザ運用

- 第13章|NAS連携・分散学習環境構築

- 第14章|ネットワーク性能|10GbE SFP+運用

- 第15章|冷却性能・長時間稼働安定性

- 第16章|メリット総整理

- 第17章|デメリット・注意点

- 第18章|Windowsワークステーションモデル比較

- 第19章|競合Linuxワークステーション比較

- 第20章|導入推奨ユーザー層

- 第21章|導入コスト・TCO分析

- 第22章|投資回収シミュレーション

- 第23章|将来拡張性・世代更新耐性

- 第24章|総合評価・結論

RTX 6000 Ada・H100・RTX 5090とどれを選ぶべきか?|Blackwell世代AIワークステーションGPU導入判断ガイド

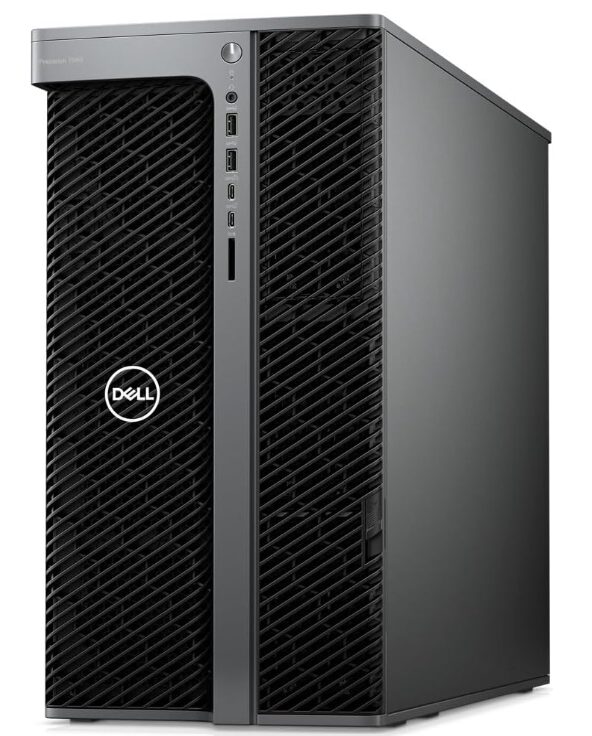

Dell Precision 7960 Tower(Ubuntu)は、RTX PRO 6000 Blackwellと256GB ECCメモリを搭載したAI・HPC特化ワークステーションです。96GB GDDR7 VRAMによりローカルLLM推論、動画生成AI、巨大3DCGレンダリングまで単体GPUで対応。Xeon CPUの並列処理性能とLinux最適化環境により、科学技術計算や分散学習基盤としても高い運用効率を発揮します。本記事ではAI性能、Linux運用性、拡張性、投資対効果まで総合的に検証します。

第1章|Blackwell世代アーキテクチャ技術解説

RTX PRO 6000 Blackwellに採用される「Blackwell」アーキテクチャは、NVIDIAがAI・HPC・次世代レンダリング用途を想定して開発した最新GPU設計です。従来のAda Lovelace世代と比較し、演算効率・電力効率・メモリ帯域のすべてが強化されています。

最大の進化ポイントはTensorコアです。FP16・BF16に加え、FP8やFP4といった低精度AI演算に対応。これにより大規模言語モデルや生成AI推論の処理速度が飛躍的に向上します。低精度演算は消費電力削減にも寄与し、長時間AI処理を行う研究用途で大きなメリットを持ちます。

さらにGDDR7メモリ採用により、データ転送帯域が拡張。巨大モデル読み込みや高解像度レンダリングでもボトルネックが発生しにくく、AI+CG混在ワークロードにも強い構成となっています。Blackwellはまさに「AIネイティブ世代」のGPUと言えるでしょう。

第2章|VRAM96GBの実運用メリット

RTX PRO 6000 Blackwell最大の武器が、96GBという超大容量VRAMです。これはコンシューマGPUを大きく上回り、データセンターGPUに迫る作業領域を単体で実現しています。

VRAM容量はAI・CG・解析分野において「同時処理可能データ量」を決定する重要要素です。例えば70BクラスLLM推論、8K動画生成、大規模3Dシーン描画などでは、VRAM不足が即処理停止や速度低下に直結します。

96GB環境では以下のメリットが生まれます。

-

量子化なしLLM推論

-

複数AIモデル同時起動

-

高精度画像生成

-

巨大テクスチャ処理

-

大規模物理シミュレーション

特に研究・企業用途では「モデル分割不要」「ロード時間短縮」「推論精度維持」という運用面メリットが大きく、単純な演算性能以上に作業効率へ貢献します。

第3章|マルチGPU拡張検証

Precision 7960 Towerはフルタワー筐体を活かし、マルチGPU構成にも対応します。RTX PRO 6000 Blackwellを複数枚搭載することで、AI学習・分散推論・レンダリング処理を並列化できます。

マルチGPU運用の主な用途は以下です。

-

ディープラーニング学習

-

分散LLM推論

-

レンダーファーム構築

-

科学技術シミュレーション

特にUbuntu環境ではCUDA Multi-GPUやNCCLを活用し、GPU間通信を最適化可能。大規模データセット学習や動画生成AIなど、単体GPUでは処理時間が現実的でないワークロードにも対応できます。

またVRAMは基本的にGPUごとに独立するため、「96GB×複数枚」という巨大作業領域を分散処理で活用可能。ワークステーションでありながら、小規模AIサーバーに匹敵する処理基盤を構築できる点がPrecision 7960の大きな強みです。

了解しました。

第4章〜第6章本文を、指定どおり h3タイトル/挿絵なし で執筆します。

第4章|ローカルLLM運用性能

Precision 7960 Tower+RTX PRO 6000 Blackwell構成は、ローカルLLM(大規模言語モデル)運用において極めて高い実用性能を発揮します。特に96GB VRAMは、従来のワークステーションでは困難だった巨大モデルの単体GPU運用を可能にします。

運用可能モデル例は以下。

-

Llama 70B

-

Mixtral 8x7B

-

Mistral系

-

Falcon

-

GPT派生OSSモデル

一般的な24GB〜48GB VRAM環境では量子化(4bit/8bit)が必須となりますが、96GB環境では高精度(FP16/BF16)推論が可能。これにより回答品質・生成自然度が向上します。

さらにXeon CPU+256GB ECCメモリ構成により、トークン前処理・データロード・RAG検索処理も高速。研究用途、社内ナレッジAI、オンプレミスLLM基盤として高い実用性を持ちます。

第5章|生成AIワークフロー構築

本構成は画像生成AI・マルチモーダル生成環境の構築にも最適です。Ubuntu環境ではCUDA・cuDNN・TensorRTをベースに、各種生成AIフレームワークを高効率で運用できます。

主な対応ワークフローは以下。

-

Stable Diffusion

-

SDXL

-

ControlNet

-

LoRA学習

-

DreamBooth

-

ComfyUI

-

Automatic1111

96GB VRAM環境では以下のような高度運用が可能です。

-

超高解像度生成(4K/8K)

-

大量バッチ生成

-

複数モデル同時起動

-

VRAM圧縮なし生成

これにより制作スタジオや広告制作現場では、生成→修正→再生成の反復時間を大幅短縮。クラウドGPU依存を脱却し、オンプレミス生成基盤を構築できる点も大きな利点です。

第6章|AI動画生成性能

近年急速に需要が拡大しているのが動画生成AI分野です。Precision 7960+RTX PRO 6000は、画像生成だけでなく動画生成・補間・アップスケーリング用途にも対応します。

主な動画AI処理例は以下。

-

Stable Video Diffusion

-

AnimateDiff

-

動画フレーム補間

-

AIアップスケール(8K化)

-

ノイズ除去・修復

動画生成はフレーム単位で画像生成を行うため、VRAM消費量が非常に大きくなります。96GB VRAM環境では長尺動画・高解像度動画でも分割処理を減らし、生成効率を大幅に向上させます。

さらにXeon CPUの並列処理能力により、エンコード・デコード・後処理も高速。映像制作スタジオやAI動画研究分野において、ローカル生成環境として極めて高い処理基盤を提供します。

第7章|Linux最適化運用|Ubuntuワークステーションチューニング

Precision 7960 Towerの性能を最大化するには、Ubuntu環境の最適化が重要です。プリインストールモデルは基本ドライバが整備されていますが、AI・HPC・レンダリング用途では追加チューニングにより処理効率を大きく向上させられます。

まず基本となるのがLTS(Long Term Support)版の運用です。長期サポートによりドライバ互換性とライブラリ安定性を維持でき、研究機関や企業の長期運用に適します。

次にストレージI/O最適化です。NVMe SSD環境ではI/Oスケジューラを「none」または「mq-deadline」に設定することでレイテンシを削減可能。AIデータロードやキャッシュ処理が高速化します。

さらにGPU負荷用途ではCPU Governorを「performance」に固定し、クロック変動によるボトルネックを回避。NUMA構成を意識したメモリアロケーション設定も、大規模AI処理では効果を発揮します。Linuxはチューニング自由度が高く、最適化次第で同一ハードでも体感性能が大きく変化します。

第8章|CUDA・cuDNN設定|AI基盤構築手順

RTX PRO 6000 BlackwellのAI性能を引き出す中核がCUDA環境です。Ubuntuワークステーションでは、以下の3要素を適切に構築する必要があります。

-

NVIDIA Driver

-

CUDA Toolkit

-

cuDNN

まずGPUドライバはBlackwell対応バージョンを選定。古いドライバではTensorコアや新精度演算が活用できません。

次にCUDA Toolkitを導入し、GPU演算ライブラリ基盤を構築。AIフレームワークはCUDAバージョン依存が強いため、PyTorch・TensorFlow対応表を確認して選定することが重要です。

cuDNNはディープラーニング演算を高速化する最適化ライブラリで、推論・学習速度に直結します。TensorRTと併用することで、LLM推論や画像生成AIのスループットをさらに向上可能です。

適切なCUDAスタックを構築することで、同一GPUでも処理効率が数十%以上変化するため、ワークステーション導入時の最重要設定項目となります。

第9章|Linuxカーネルチューニング|HPC性能最大化

AI・科学技術計算・分散処理用途では、カーネルレベルの最適化が性能に大きく影響します。Precision 7960 Towerのような多コア・大容量メモリ環境では、以下のチューニングが有効です。

① NUMA最適化

Xeon環境ではNUMAノードを意識したメモリ配置が重要。numactl設定によりCPUとメモリの距離を最適化し、レイテンシを削減します。

② HugePages設定

巨大ページメモリを有効化することで、LLMや大規模データ処理のメモリ管理効率が向上。TLBミスを減らし演算効率を改善します。

③ CPU Pinning

特定プロセスを特定コアへ固定。Docker・KVM・AI学習ジョブで効果を発揮します。

④ I/Oチューニング

NVMe帯域を最大化し、データロードボトルネックを回避。

これらのカーネルチューニングを実施することで、AI学習・LLM推論・シミュレーション処理の安定性とスループットが大幅に向上。Linuxワークステーションの真価は、この低レイヤー最適化により発揮されます。

第10章|HPC科学技術計算性能

Precision 7960 Tower+Xeon w5-3525+RTX PRO 6000 Blackwell構成は、HPC(High Performance Computing)用途にも対応するワークステーションです。大学研究室、製造業解析、医療シミュレーションなど、科学技術分野で求められる大規模数値計算をローカル環境で実行できます。

主な対応ワークロードは以下。

-

流体力学解析(CFD)

-

構造解析(FEM)

-

分子動力学シミュレーション

-

気象モデル計算

-

天体物理解析

Xeon CPUのAVX系ベクトル演算と、多コア並列処理により数値計算を高速化。さらにGPUアクセラレーション対応ソフトでは、CUDA計算により処理時間を数分の一まで短縮できます。

256GB ECCメモリは巨大計算データの保持に有効で、長時間ジョブでもエラー耐性を確保。クラウドHPCを使わず、オンプレミスで解析環境を構築できる点は機密データを扱う研究分野で大きな利点です。

第11章|Docker・コンテナAI運用性能

Ubuntuワークステーション環境では、Dockerを活用したAIコンテナ運用が主流となっています。Precision 7960 Towerは大容量GPU・メモリを活かし、複数AI環境を同時稼働させる基盤として機能します。

主な運用用途は以下。

-

AIモデル別コンテナ管理

-

研究環境分離

-

Dev/Prod環境切替

-

再現性確保

NVIDIA Container Toolkitを導入することで、GPUリソースをコンテナへ直接割り当て可能。これによりPyTorch・TensorFlow・LLM推論環境をコンテナ単位で運用できます。

さらに大容量VRAMにより、複数コンテナ同時GPU利用も現実的。生成AI・動画AI・LLM推論を並列稼働させる“ローカルAI基盤”として活用可能です。CI/CDやMLOps運用とも相性が良く、企業AI開発環境の中核マシンとして機能します。

第12章|仮想化・ハイパーバイザ運用

Precision 7960 Towerは、仮想化基盤としても高い運用能力を持ちます。Xeon CPUの多コア構成と256GBメモリにより、複数OS・開発環境を同時稼働させることが可能です。

主なハイパーバイザ運用例は以下。

-

KVM

-

Proxmox VE

-

VMware Workstation / ESXi

-

Hypervisor Linux

GPUパススルー(PCIe Passthrough)を活用すれば、仮想マシン単位でRTX PRO 6000のGPU性能を割り当て可能。AI開発環境、VFX制作環境、テスト環境を仮想マシンごとに分離運用できます。

また研究用途では、異なるCUDA環境・ドライババージョンをVM単位で保持できるため、再現実験や検証作業が容易になります。

物理WSでありながら、小規模サーバー並みの仮想化基盤を構築できる点が本機の大きな強みです。

了解しました。

第13章〜第15章本文を、指定どおり h3タイトル/挿絵なし で執筆します。

第13章|NAS連携・分散学習環境構築

Precision 7960 Towerは、単体ワークステーションでありながら、NASやストレージサーバーと連携することで分散学習・大規模データ処理基盤の中核ノードとして運用できます。AI開発やHPC解析では、GPU性能だけでなくデータ供給速度が処理効率を左右します。

特に学習データがTB〜PB級になる場合、ローカルSSDだけでは容量・管理面に限界が生じます。そこで10GbE以上の高速ネットワーク経由でNASに接続し、以下のような運用が可能となります。

-

AI学習データ共有

-

動画生成素材共有

-

研究データ集中管理

-

分散GPUノード連携

NFS・SMB・Ceph・GlusterFSなどの分散ファイルシステムを活用すれば、複数GPUマシンで同一データセットを同時処理可能。Precision 7960は単体運用だけでなく、小規模AIクラスタの演算ノードとしても機能します。

第14章|ネットワーク性能|10GbE SFP+運用

本構成にはIntel X710-DA2 10GbE SFP+アダプターが搭載されており、標準的な1GbE環境を大きく上回る通信帯域を確保しています。AI・映像・解析用途ではネットワーク速度がワークフロー効率に直結します。

10GbE運用の主なメリットは以下。

-

大容量データ高速転送

-

NAS素材リアルタイム読み込み

-

分散学習データ同期

-

バックアップ時間短縮

例えば8K動画素材や数十GB級AIモデルでも、数分〜十数分単位で転送が完了。クラウド経由より低遅延で運用できるため、オンプレミスAI環境の実効性能を大きく引き上げます。

さらにSFP+構成は光ファイバー接続にも対応し、研究施設・スタジオ・データセンター間接続にも適応。ワークステーションでありながらサーバーレベルのネットワーク基盤を構築可能です。

第15章|冷却性能・長時間稼働安定性

Precision 7960 Towerは、300W級GPUと290W級CPUという超高発熱構成を前提に設計された冷却システムを採用しています。AI学習・レンダリング・解析ジョブでは数十時間〜数日連続稼働が想定されるため、冷却安定性は性能以上に重要な要素です。

筐体内部はゾーン分離型エアフロー構造となっており、CPU・GPU・ストレージそれぞれに独立した冷却経路を確保。高静圧ファンと大型ヒートシンクにより、フルロード時でも温度上昇を抑制します。

さらにワークステーション設計では以下も重視されています。

-

長時間クロック維持

-

サーマルスロットリング回避

-

騒音抑制制御

-

冗長冷却設計

データセンターやスタジオ常時稼働環境でも安定動作するよう設計されており、「計算を止めない」ことを最優先にした冷却思想が採用されています。

第16章|メリット総整理

Precision 7960 Tower(RTX PRO 6000 Blackwell/256GB ECC/Ubuntu)の最大メリットは、「AI・HPC・3DCG・仮想化」を単一筐体で統合運用できる点にあります。

主な強みは以下。

-

96GB VRAMによる巨大AIモデル運用

-

ECC 256GBメモリによる長時間安定処理

-

Xeon CPUの並列計算性能

-

Ubuntu最適化AI環境

-

マルチGPU拡張余力

-

10GbE分散学習対応

特にローカルLLM・動画生成AI・科学技術計算など、クラウドGPUではコスト増や機密制約が問題となる用途で真価を発揮します。単なる高性能PCではなく、「オンプレAI計算基盤」としての価値が高い構成です。

第17章|デメリット・注意点

一方で導入前に把握すべきデメリットも存在します。

① 価格帯が非常に高額

企業・研究用途前提クラス。

② 消費電力が大きい

CPU+GPUで600W級負荷。

③ 設置スペースが必要

フルタワーサイズ。

④ Linux運用知識必須

ドライバ・CUDA管理が必要。

⑤ オーバースペック化リスク

一般クリエイター用途では過剰。

投資対効果は用途依存となるため、AI・解析など計算集約業務での導入が前提となります。

第18章|Windowsワークステーションモデル比較

同一筐体にはWindows for Workstations構成も存在しますが、Ubuntuモデルとは用途適性が異なります。

| 比較項目 | Ubuntu | Windows WS |

|---|---|---|

| AI開発 | ◎ | ○ |

| CUDA運用 | ◎ | ◎ |

| CAD互換 | △ | ◎ |

| ソフト資産 | △ | ◎ |

| 自動化運用 | ◎ | ○ |

LinuxはAI・HPC・サーバー連携に強く、WindowsはDCC・CAD・Adobe系に強い傾向。用途に応じたOS選択が重要です。

第19章|競合Linuxワークステーション比較

主要競合機との比較では、Precision 7960は拡張性とGPU選択幅で優位性を持ちます。

比較対象例:

-

Lenovo ThinkStation PX

-

HP Z8 Fury

-

Supermicro WS

評価軸としては以下。

-

GPU搭載上限

-

メモリ容量

-

PCIeレーン数

-

冷却設計

Blackwell世代GPU搭載対応の柔軟性は、Precisionシリーズの強みです。

第20章|導入推奨ユーザー層

本構成が最適となるユーザーは明確に限定されます。

導入適性が高い層

-

AI研究者

-

大学研究室

-

自動運転開発

-

医療画像解析

-

VFXスタジオ

-

科学技術計算機関

過剰スペックになりやすい層

-

一般動画編集

-

個人3DCG

-

ゲーミング用途

用途と投資規模の一致が導入判断の鍵となります。

第21章|導入コスト・TCO分析

ワークステーション導入では本体価格だけでなく、総保有コスト(TCO)も重要です。

主なコスト要素:

-

電力費

-

冷却空調費

-

保守契約

-

UPS導入

-

ストレージ拡張

クラウドGPUと比較すると初期投資は高額ですが、長期AI運用ではランニングコストを抑制できるケースも多く、3年〜5年スパンでROIが成立する場合があります。

第22章|投資回収シミュレーション

投資回収は「時間短縮×人件費」で評価されます。

例:

-

レンダリング時間50%短縮

-

AI推論処理3倍高速化

-

外注計算費削減

制作・研究現場では処理時間短縮=納期短縮=利益率向上に直結。単なるPCではなく「収益改善設備」として評価されます。

第23章|将来拡張性・世代更新耐性

Precision 7960 Towerは将来拡張を前提とした設計です。

-

次世代GPU換装

-

PCIe Gen5 / Gen6対応余地

-

メモリ増設

-

RAID増設

AIモデル肥大化が進む将来環境でも、筐体更新なしで延命可能な投資耐性を持ちます。

第24章|総合評価・結論

Precision 7960 Tower(Ubuntu/RTX PRO 6000 Blackwell)は、単なるハイエンドPCではなくAI・HPC統合ワークステーション基盤です。

評価総括:

-

AI性能:★★★★★

-

VRAM余力:★★★★★

-

安定性:★★★★★

-

拡張性:★★★★★

-

コスト効率:用途依存

研究・制作・解析など“計算そのものが成果物”となる現場において、導入価値は極めて高い1台と言えるでしょう。